DeepSeek soll Zugriff auf Zehntausende GPU-Beschleuniger zur Entwicklung der eigenen KI-Modelle haben, darunter auch H100-GPUs, die unter die US-Exportverbote fallen. Die kolportierten Kosten von knapp 5,6 Millionen US-Dollar für DeepSeek v3 stellen vermutlich nur einen kleinen Teil der Gesamtrechnung dar.

Im Paper zum V3-Modell schreibt DeepSeek von einem vergleichsweise kleinen Rechenzentrum mit 2048 H800-Beschleunigern von Nvidia. Die Firma rechnet mit hypothetischen Mietkosten von 2 US-Dollar pro Stunde und H800-GPU. Bei aufsummiert knapp 2,8 Millionen Rechenstunden (verteilt auf 2048 GPUs) kommen die 5,6 Millionen US-Dollar zustande.

Die Entwickler selbst führen allerdings eine Einschränkung an: “Bitte beachte, dass die oben genannten Kosten nur das offizielle Training von DeepSeek-V3 beinhalten und nicht die Kosten, die mit früheren Forschungs- und Ablationsexperimenten zu Architekturen, Algorithmen oder Daten verbunden sind.”

…

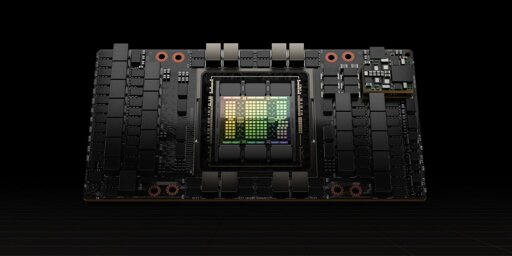

Semianalysis hat sich mit einer realistischen Kostenaufstellung beschäftigt. Laut den Analysten hat DeepSeek über das Mutterunternehmen High-Flyer Zugriff auf etwa 60.000 Nvidia-Beschleuniger: 10.000 A100 aus der Ampere-Generation, bevor die US-Exportbeschränkungen in Kraft traten, 10.000 H100 vom Graumarkt, 10.000 für China angepasste H800 und 30.000 H20, die Nvidia nach neueren Exporteinschränkungen auflegte.

…

Allein die Entwicklung der Caching-Technik Multi-Head Latent Attention (MLA) soll Monate beansprucht haben. Dabei komprimiert das KI-Modell alle generierten Token, damit es bei neuen Abfragen schnell auf die Daten zugreifen kann, ohne viel Speicherplatz zu beanspruchen.

Eine zweite Neuerung dürfte ebenfalls einige Ressourcen in Anspruch genommen haben: “Dual Pipe”. DeepSeek nutzt einen Teil der Streaming-Multiprozessoren (SMs) in Nvidias GPUs als eine Art virtuelle Data Processing Unit (DPU), wie Nextplatform herausstellt. Sie kümmern sich unabhängig vom Prozessor um die Datenbewegungen in und zwischen den KI-Beschleunigern – mit viel geringeren Wartezeiten als beim Einsatz von CPUs, was die Effizienz steigert.

Im Paper zum mächtigeren R1-Modell macht DeepSeek keinerlei Angaben zur eingesetzten Hardware. Hier wäre der Einsatz eines kleinen Rechenzentrums noch unglaubwürdiger. Ausgehend von einem X-Beitrag häuften sich zuletzt Meldungen, dass DeepSeek für R1 auch KI-Beschleuniger von Huawei verwenden könnte.

Na und? Haben trotzdem gezeigt dass die Amerikaner keinen Moat haben

…und ein Leak zeigt auch, weshalb: Weil man etliche Teile von OpenAI geklaut hat…

Du meinst die Knowledge Distillation mit Output von „Open“AI ?

Ja, da habe ich wirklich enorm Mitleid. „Open“AI ist ja eine Firma, die bekanntlich das geistige Eigentum anderer respektiert, insbesondere zum Training ihrer Modelle. Da ist es natürlich verständlich, dass sie selbst von anderen ein anderes Verhalten einfordern, als sie selbst an den Tag legen

Eine Firma hat statistiken in ihrer pressemeldung nach allen regeln der kunst geschöhnt und aktienmärkte sind darauf reingefallen weil sowas ja noch keine firma jemals nicht gemacht hat?

überaschtes pikatchu

Etwas wird nicht dadurch besser, weil es vorher schon mal wer gemacht hat.

darum gings ja auch nicht sonder das mans von ner meile hat hommen sehn